He aquí por qué la gente confía en el juicio humano sobre los algoritmos

Pensarías que después de años de usar Google Maps confiamos en que sabe lo que está haciendo. Aún así, pensamos: «Tal vez tomar los caminos traseros sería más rápido».

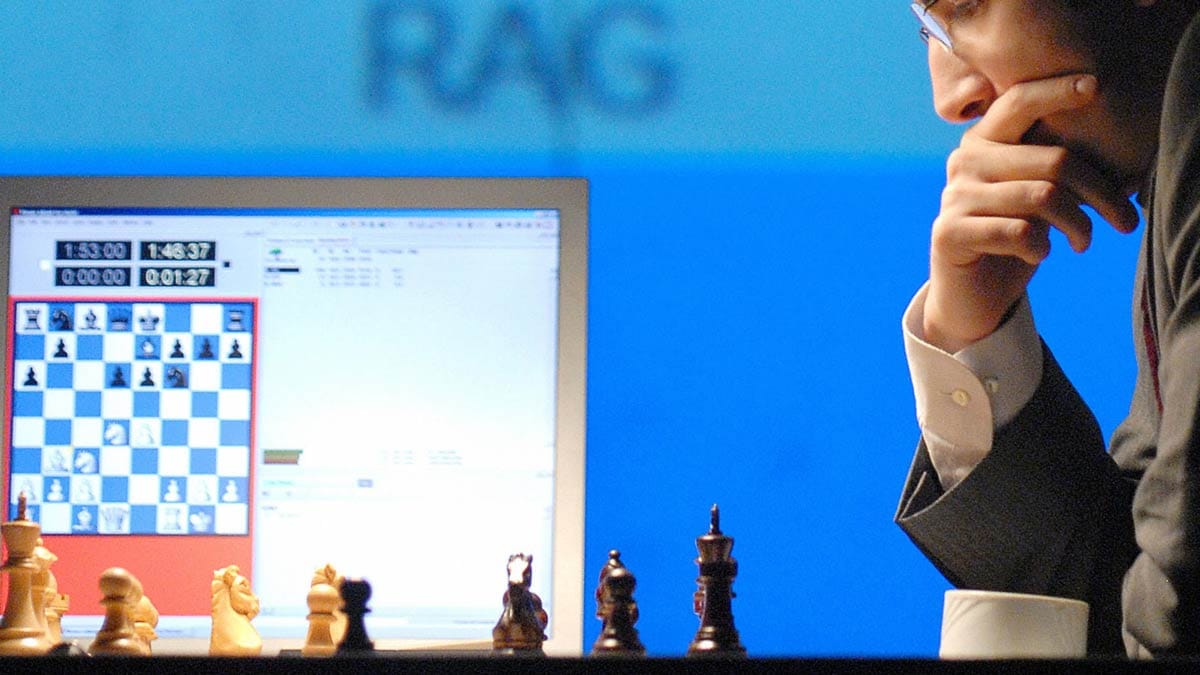

Este es un ejemplo de lo que los investigadores llaman «aversión a los algoritmos»: incluso cuando un algoritmo supera sistemáticamente el juicio humano, la gente prefiere ir con su instinto. Esto puede tener costos muy reales, desde quedarse atascado en el tráfico hasta perder un objetivo de ventas o diagnosticar erróneamente a un paciente.

Los algoritmos hacen mejores evaluaciones en una amplia gama de contextos, y puede parecer lógico que si la gente entendiera que confiarían más. De hecho, ver cómo funcionan los algoritmos empeora las cosas, porque significa que ver el algoritmo ocasionalmente comete un error.

En un artículo publicado el año pasado, Berkeley Dietvorst, Joseph Simmons y Cade Massey de Wharton descubrieron que la gente confía aún menos en los algoritmos si los ha visto fracasar, incluso un poco. Y son más difíciles con los algoritmos de esta manera que en otras personas. Errar es humano, pero cuando un algoritmo comete un error es probable que no volvamos a confiar en él.

En uno de los experimentos, se pidió a los participantes que examinaran los datos de admisión de MBA y adivinaran qué tan bien habían ido los estudiantes durante el programa. Luego se les dijo que ganarían una pequeña cantidad de dinero por conjeturas precisas y se les dio la opción de presentar sus propias estimaciones o enviar predicciones generadas por un algoritmo. A algunos participantes se les mostraron datos sobre qué tan bien habían resultado sus conjeturas anteriores, a otros se les mostró cuán preciso era el algoritmo, a otros no se les mostró ninguno y otros se mostraron ambos.

Los participantes que habían visto los resultados del algoritmo tenían menos probabilidades de apostar por él, aunque también se les mostrara su rendimiento, y pudieran ver que el algoritmo era superior. Y aquellos que habían visto los resultados tenían menos probabilidades de creer que el algoritmo funcionaría bien en el futuro. Este hallazgo tuvo lugar en varios experimentos similares en otros contextos, e incluso cuando los investigadores hicieron que el algoritmo fuera más preciso para acentuar su superioridad.

Tampoco es todo egoísmo. Cuando la elección era entre apostar por el algoritmo y apostar a otra persona, los participantes tenían más probabilidades de evitar el algoritmo si habían visto cómo funcionaba y, por lo tanto, inevitablemente, lo habían visto errado.

Cuando se les pidió que se explicaran, la respuesta más común de los participantes fue que «los pronosticadores humanos eran mejores que el modelo para mejorar con la práctica [y] aprender de los errores». No importa que los algoritmos también puedan mejorar o que el aprendizaje con el tiempo no forma parte del estudio. Parece que nuestra fe en el juicio humano está vinculada a nuestra creencia en nuestra propia capacidad de mejorar.

Si mostrar resultados no ayuda a evitar la aversión a los algoritmos, se permite la entrada humana. En un próximo artículo, los mismos investigadores descubrieron que las personas están mucho más dispuestas a confiar y utilizar algoritmos si se les permite modificar un poco el resultado. Si, digamos, el algoritmo predijo que un estudiante actuaría en el 10% superior de su clase de MBA, los participantes tendrían la oportunidad de revisar esa predicción hacia arriba o hacia abajo en unos pocos puntos. Esto hizo que sean más propensos a apostar por el algoritmo y menos probabilidades de perder la confianza después de ver cómo funcionaba.

Por supuesto, en muchos casos la adición de insumos humanos empeoró la previsión final. Nos enorgullecemos de nuestra capacidad de aprender, pero lo único que parece que no podemos entender es que normalmente es mejor confiar en que el algoritmo sabe mejor.

— Escrito por Walter Frick