Cómo el aprendizaje automático nos empuja a definir la equidad

Resumen.

Junto con el crecimiento de la IA han surgir serias preguntas sobre nuestra capacidad para construir algoritmos imparciales y «justos». Y es cierto que sin intervención, los algoritmos de aprendizaje automático reflejarán cualquier sesga en los datos subyacentes. Pero precisamente porque ML nos obliga a instruirla de manera muy precisa sobre qué tipo de resultados encontraremos éticamente aceptables, también nos está dando las herramientas para tener estas discusiones de manera más clara y productiva. Estamos definiendo un nuevo vocabulario y un conjunto de conceptos para hablar de equidad.

El sesgo es el pecado original del aprendizaje automático. Está integrado en la esencia del aprendizaje automático: el sistema aprende de los datos y, por lo tanto, es propenso a captar los sesgos humanos que representan los datos. Por ejemplo, es probable que un sistema de contratación de ML capacitado sobre el empleo existente en los Estados Unidos «aprenda» que ser mujer correlaciona mal con ser CEO.

Limpiar los datos tan a fondo que el sistema no descubra correlaciones perniciosas y ocultas puede ser extraordinariamente difícil. Incluso con el mayor cuidado, un sistema ML podría encontrar patrones sesgados tan sutiles y complejos que se esconden de la mejor intencionada atención humana. De ahí el necesario enfoque actual entre los informáticos, los encargados de formular políticas y cualquier persona interesada en la justicia social en cómo mantener el sesgo fuera de la IA.

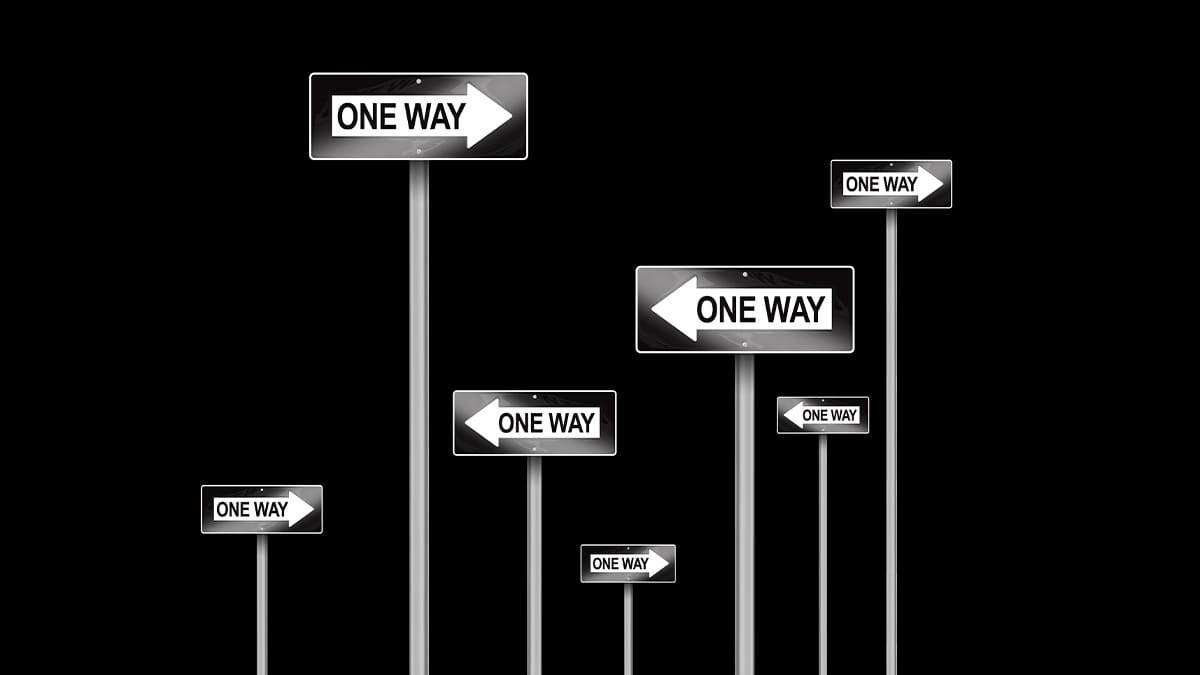

Sin embargo, la propia naturaleza del aprendizaje automático también puede estar trayéndonos a pensar en la equidad de formas nuevas y productivas. Nuestros encuentros con el aprendizaje automático (ML) están empezando a darnos conceptos, vocabulario y herramientas que nos permiten abordar cuestiones de parcialidad y equidad de manera más directa y precisa que antes.

Durante mucho tiempo hemos tomado la justicia como un primitivo moral. Si le preguntas a alguien un ejemplo de injusticia, las probabilidades son sorprendentemente altas de que hablen de dos niños que reciben diferentes números de galletas. Eso es claramente injusto, a menos que haya alguna diferencia relevante entre ellos que justifique la disparidad: uno de los niños es mayor y más grande, o aceptó hacer tareas adicionales a cambio de una galleta,. En esta simple formulación, la equidad se define como la igualdad de trato de las personas a menos que exista alguna distinción pertinente que justifique el trato desigual.

Pero, ¿qué constituye una «distinción pertinente»? El hecho es que estamos de acuerdo mucho más fácilmente sobre lo que es injusto que lo que es justo. Todos estamos de acuerdo en que la discriminación racial es errónea, pero sesenta años después seguimos discutiendo si la Acción Afirmativa es un remedio justo.

Por ejemplo, todos estamos de acuerdo en que en la década de 1970, era injusto que las mujeres músicas constituyeran tan poco como el 5% de la sinfonía de los cinco primeros orquestas. En este caso, podríamos estar de acuerdo en que el actual instituto de orquestas remedios parece mucho más justo: al hacer que los solicitantes audicionen detrás de una cortina para enmascarar su género, el porcentaje de mujeres en las cinco mejores orquestas sinfónicas aumentó al 25% en 1997, y ahora al 30%.

Pero, ¿es suficiente un proceso ciego al género para que el resultado sea realmente justo? Tal vez los prejuicios culturales confieran ventajas no biológicas a los músicos masculinos; si se aceptaba a más hombres en los mejores conservatorios, por ejemplo, podrían haber recibido una mejor educación musical. Tal vez los estándares de performance en la música se han formado a lo largo de los siglos alrededor de rasgos o preferencias típicamente masculinas, como el tamaño de palma o la agresividad de la performance. ¿Y es suficiente un 30% para declarar que las orquestas ahora son justas en su trato a las mujeres? ¿Tal vez el desglose por género de los músicos debería ser del 51% para reflejar la demografía general de género nacional? ¿O tal vez debería reflejar el porcentaje de candidatos masculinos y femeninos para escaños en la orquesta? ¿O quizás más alto que eso para corregir parcialmente los siglos de sesgo histórico que han llevado a la representación excesiva de los hombres en las orquestas? (Por no mencionar que toda esta discusión asume que el género es binario, que no lo es).

El aprendizaje automático puede ayudarnos con este tipo de discusiones porque requiere que le instruyamos de manera muy precisa sobre qué tipo de resultados encontraremos éticamente aceptables. Nos da las herramientas necesarias para que estas discusiones —a menudo discusiones — de manera más clara y productiva.

Estas herramientas incluyen un vocabulario que surge de la tarea más común del aprendizaje automático: decidir en qué compartimento poner una entrada determinada. Si la entrada es una imagen en tiempo real de un tomate en una cinta transportadora en una fábrica de salsa de espagueti, los contenedores podrían estar etiquetados como «Aceptable» o «Descartar». Cada entrada se asignará a bin con un nivel de confianza adjunto: un 72% de certeza de que este tomate es comestible, por ejemplo.

Si clasificar los tomates es la tarea básica de tu sistema, entonces te importará cuántos tomates se clasifican mal: cuántos tomates buenos está poniendo el ML en la pila Descartar y cuántos tomates malos está poniendo en el contenedor Aceptable, aprobaciones erróneas y oportunidades perdidas. Y debido a que las asignaciones a los compartimentos siempre se basan en un nivel de confianza, ML ofrece a sus diseñadores deslizadores con los que jugar para ajustar los resultados para reflejar diferentes definiciones de equidad.

Por ejemplo, si se trata de su fábrica de tomates, es posible que le importe más la precisión general de su nueva aplicación de clasificación de tomates ML. Pero un regulador puede estar más preocupado por los tomates malos que entran en la papelera Aprobada que los buenos tomates que se lanzan al contenedor de descartes. O, si eres un sucio dueño de una fábrica de tomates, puedes estar más molesto tirando buenos tomates que por incluir algunos tomates podridos en tu salsa.

ML requiere que seamos completamente claros acerca de lo que queremos. Si le preocupa que los tomates malos se conviertan en su salsa, tendrá que decidir con qué porcentaje de tomates malos pueden vivir usted (y sus clientes y probablemente sus abogados). Puede controlar este porcentaje ajustando el nivel de confianza necesario para colocar un tomate en el compartimento aprobado: ¿desea establecer el nivel de confianza umbral en 98% o reducirlo a solo 60%? A medida que muevas el control deslizante hacia la izquierda o hacia la derecha, enviarás más tomates buenos a la papelera de Descartar, o pondrás más tomates malos en el contenedor aprobado.

En el lenguaje de ML, los buenos tomates pasados por alto que se sientan en la papelera de Descartar son negativos falsos, y los tomates malos puestos en el contenedor Aprobado son falsos positivos.

Estos términos resultan útiles cuando hablamos de procesos como clasificar solicitudes de préstamo en contenedores aprobados o rechazados. (A los efectos de esta hipotética, estamos ignorando cualquier regulación que rija los procesos de aprobación de préstamos). Digamos que el 30% de los solicitantes son mujeres, pero solo el 10% de las solicitudes en la papelera Aprobada provienen de mujeres. Pero en lugar de mirar el porcentaje de aprobaciones que se destinan a las mujeres, o el porcentaje de hombres y mujeres que incumplan sus préstamos, tal vez deberíamos examinar si el porcentaje de falsos positivos en el compartimento Mujeres Rechazadas es mayor que el porcentaje de falsos positivos en el compartimento Hombres rechazados.

Los tipos de equidad que hemos discutido aquí, y más, también han recibido definiciones precisas por parte de los investigadores en el Campo ML, con nombres como «Paridad demográfica», «Paridad de tasa predictiva» y «Equidad contrafáctica». Tenerlos disponibles cuando se habla de estas cuestiones con expertos puede hacer que esas discusiones sean más fáciles, con una mayor comprensión en todos los lados del argumento. No nos dicen qué tipo de justicia adoptar en cualquier situación, pero nos facilitan tener argumentos productivos sobre la cuestión.

Esto es cierto también en un nivel más alto de abstracción, ya que podemos decidir qué cuenta como éxito para un sistema ML. Por ejemplo, podríamos entrenar a nuestro clasificador de aplicaciones de préstamo ML para optimizarse para obtener el mayor beneficio para nuestro negocio. O por los ingresos más altos. O para el número máximo de clientes. Incluso podríamos decidir por razones de justicia económica que queremos conceder algunos préstamos a las personas más pobres, en lugar de ir siempre por las personas más ricas de la zona. Nuestro sistema ML debe permitirnos juzgar el riesgo, ajustar el porcentaje de personas de ingresos más bajos que queremos en el compartimento aprobado, o establecer un nivel mínimo de rentabilidad para los préstamos que hacemos.

ML también deja claro que no siempre podemos, o incluso normalmente, optimizar nuestros resultados para cada valor que podamos tener. Por ejemplo, la empresa de préstamos puede encontrar, en esta hipotética, que admitir a más solicitantes de ingresos bajos en el compartimento aprobado afecta al porcentaje de mujeres en ese compartimento. Es concebible que no se pueda optimizar simultáneamente el sistema para ambos. En tal caso, es posible que desee encontrar otro valor que esté dispuesto a modificar para crear resultados más justos tanto para las personas de bajos ingresos como para las mujeres. Tal vez si aumenta el riesgo de su empresa en una cantidad aceptable, puede lograr ambos objetivos. Los sistemas de aprendizaje automático nos dan las palancas para hacer estos ajustes y anticiparnos a sus resultados.

A medida que observamos niveles más altos de abstracción, desde el uso de deslizadores para ajustar las mezclas en los contenedores, hasta preguntas sobre la optimización de valores posiblemente inconsistentes, ML nos está enseñando que la equidad no es simple sino compleja, y que no es un absoluto sino una cuestión de compensación.

Las decisiones que la indefensa literalidad de ML requiere de nosotros, naturalmente, pueden conducir a discusiones que suenan menos como argumentos de alto nivel sobre la moral —o argumentos cargados de jerga sobre la tecnología— y más como argumentos políticos entre personas con diferentes valores: Gran salsa de tomate, o salsa barata que maximiza nuestro beneficio? ¿Aumentar el porcentaje de músicas femeninas en la orquesta o mantener la configuración actual de los instrumentos? ¿Conceder préstamos a personas de bajos ingresos, pero quizás reducir el porcentaje de mujeres en la mezcla?

Si el aprendizaje automático plantea estas preguntas con una nueva precisión, nos da un vocabulario para hablar de ellas y nos permite probar ajustes para ver las mejores maneras de optimizar el sistema para los valores que nos preocupan, entonces eso es un paso adelante. Y si el aprendizaje automático nos lleva a hablar de remedios a situaciones injustas en términos de valores que nos preocupan, dispuestos a hacer compromisos realistas, entonces eso tampoco es un mal modelo para muchos argumentos morales.

— Escrito por David Weinberger